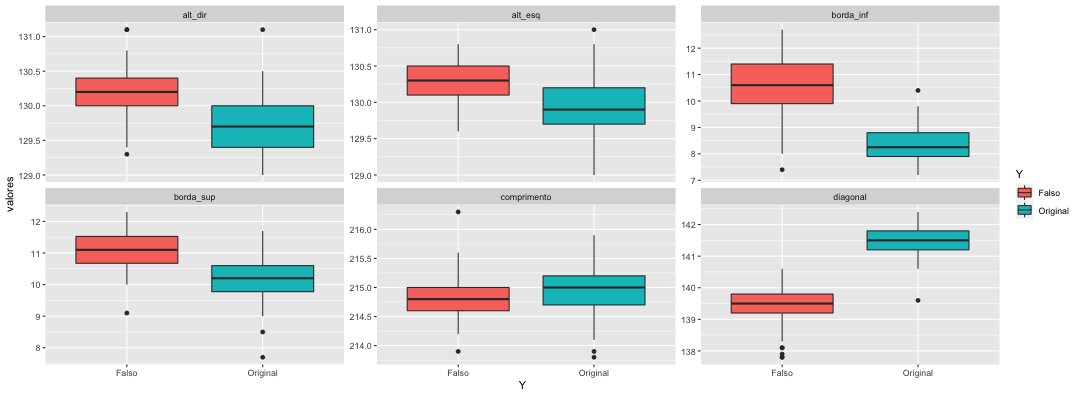

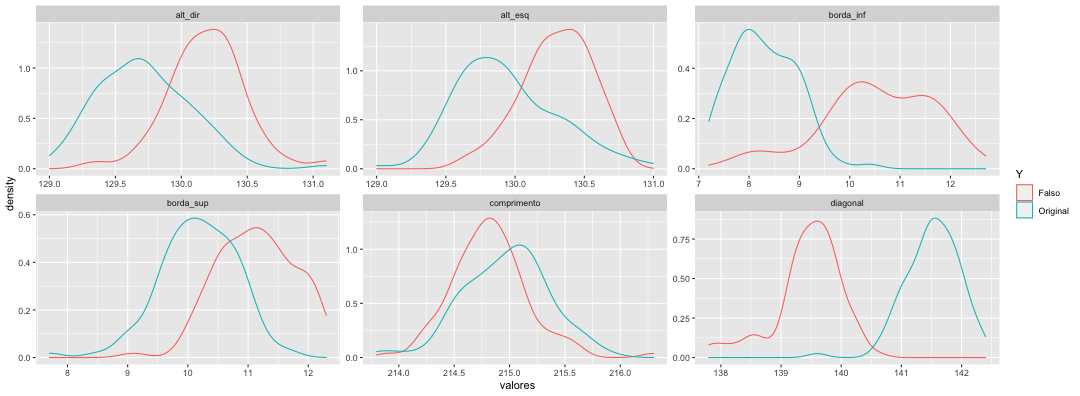

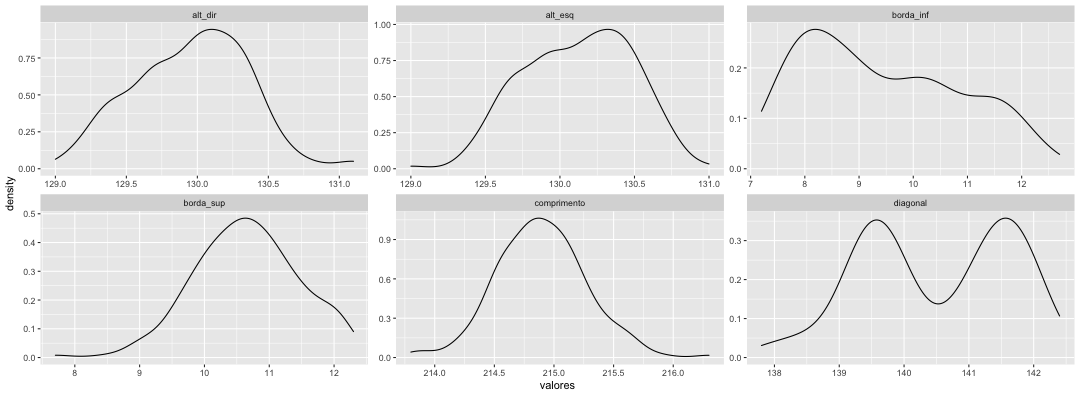

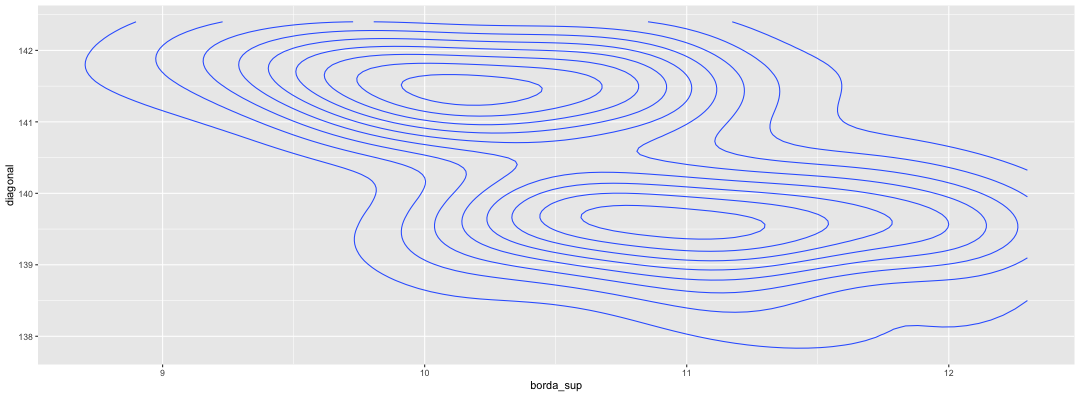

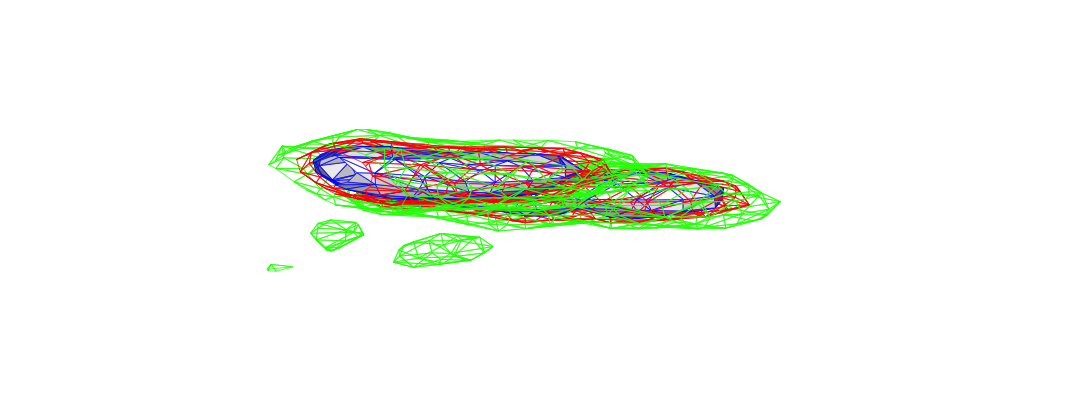

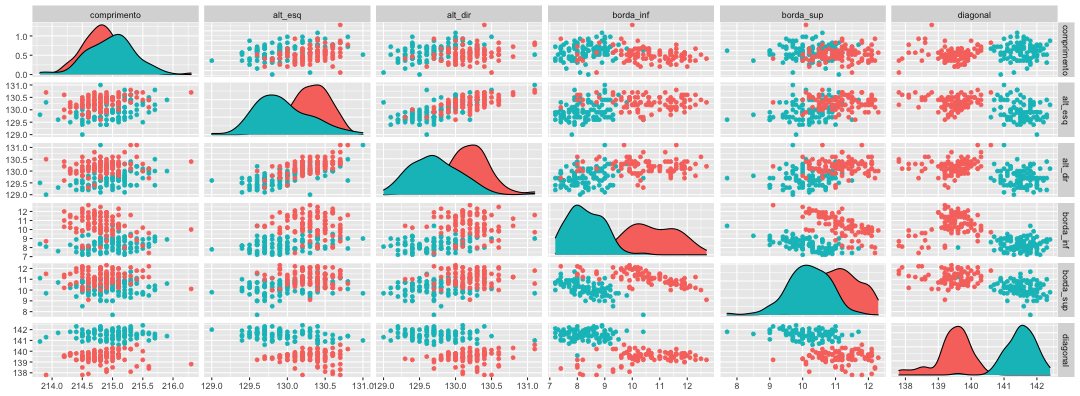

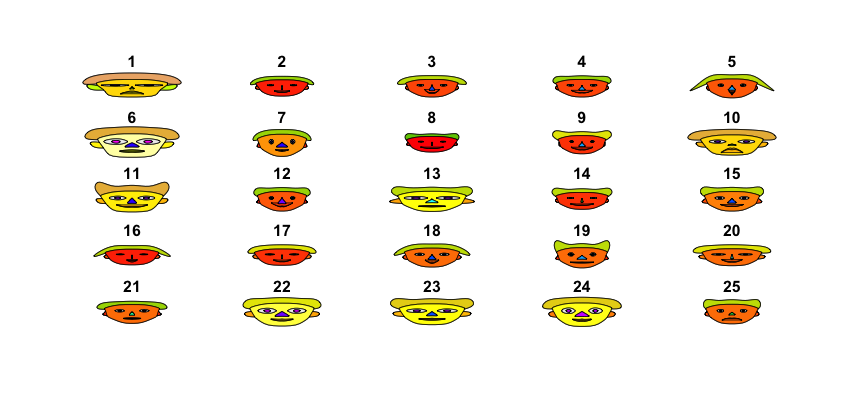

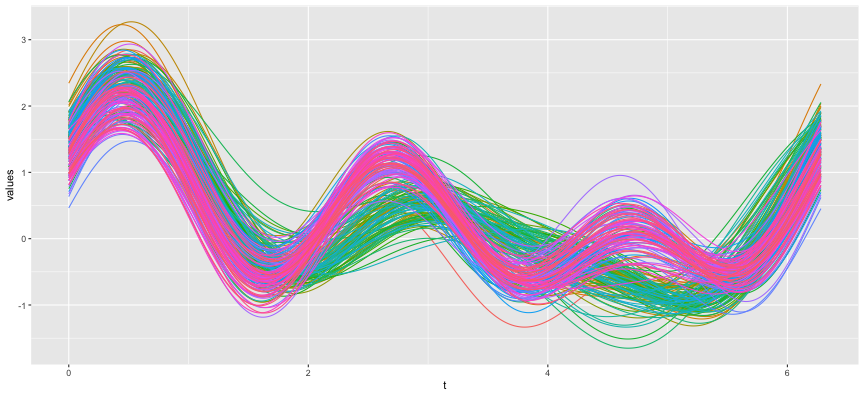

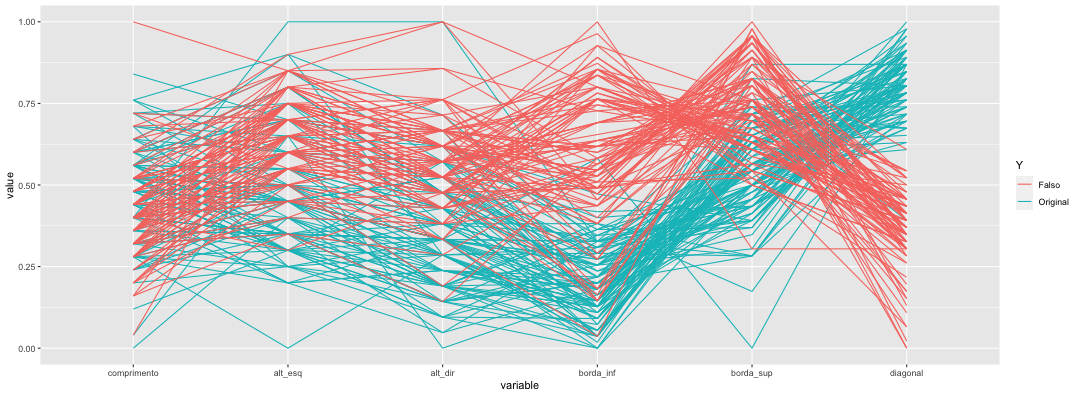

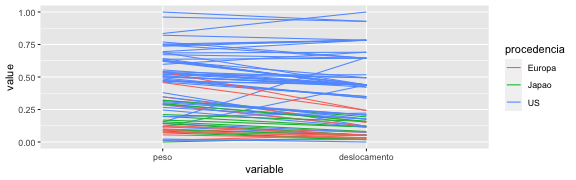

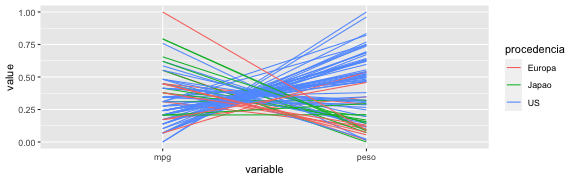

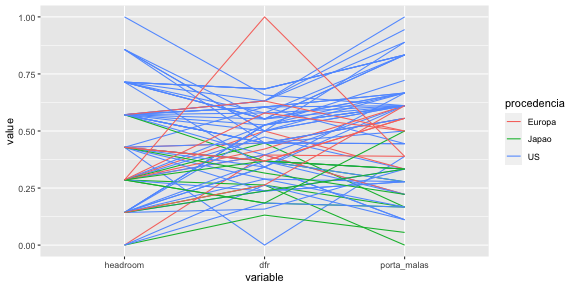

class: center, middle, inverse, title-slide .title[ # Métodos em Análise Multivariada (ME731) ] .subtitle[ ## Introdução à Análise Multivariada. ] .author[ ### Prof. Carlos Trucíos <br><a href="http://ctruciosm.github.io"> <i class="fa fa-desktop fa-fw"></i> ctruciosm.github.io</a><br> <a href="mailto:ctrucios@unicamp.br"><i class="fa fa-paper-plane fa-fw"></i> ctrucios@unicamp.br</a><br> ] .institute[ ### Instituto de Matemática, Estatística e Computação Científica, </br> Universidade Estadual de Campinas ] --- layout: true <a class="footer-link" href="http://ctruciosm.github.io">ctruciosm.github.io — Carlos Trucíos (IMECC/UNICAMP)</a> <style type="text/css"> .remark-slide-content { font-size: 26px; padding: 1em 3.5em 1em 3.5em; } </style> --- <div> <style type="text/css">.xaringan-extra-logo { width: 100px; height: 150px; z-index: 0; background-image: url(imagens/unicamp.png); background-size: contain; background-repeat: no-repeat; position: absolute; top:1em;right:1em; } </style> <script>(function () { let tries = 0 function addLogo () { if (typeof slideshow === 'undefined') { tries += 1 if (tries < 10) { setTimeout(addLogo, 100) } } else { document.querySelectorAll('.remark-slide-content:not(.title-slide):not(.inverse):not(.hide_logo)') .forEach(function (slide) { const logo = document.createElement('div') logo.classList = 'xaringan-extra-logo' logo.href = null slide.appendChild(logo) }) } } document.addEventListener('DOMContentLoaded', addLogo) })()</script> </div> <center> <img src="Aula_01_files/figure-html/unnamed-chunk-1-1.png" width="500" height="500" /> </center> --- <center> <img src="Aula_01_files/figure-html/unnamed-chunk-2-1.png" width="500" height="500" /> </center> --- ## Notação Sejam `\(\textbf{x}_1, \cdots, \textbf{x}_n\)` `\(n\)` observações `\(p\)`- dimensionais, ou seja `$$\textbf{x}_i = (x_{i1}, x_{i2}, \cdots, x_{ip})',$$` em que essas observações são realizações do vetor aleatório `\(p\)`-dimensional `\(\textbf{X} \in \mathbb{R}^p\)`, com `$$\textbf{X} = (X_1, X_2, \cdots, X_p)',$$` em que `\(X_1, X_2, \cdots, X_p\)` são variáveis aleatórias. Para todos os fins dessa matéria, vamos assumir que `\(\mathbb{E}(\textbf{X}) = \mu\)` e `\(\mathbb{V}(\textbf{X}) = \Sigma\)` são ambos finitos. --- ## Notação A matriz de dados será uma matriz de dimensão `\(n \times p\)` da forma: `$$\textbf{x} = \left( {\begin{array}{cccc} x_{11} & x_{12} & \cdots & x_{1p} \\ x_{21} & x_{22} & \cdots & x_{2p} \\ \vdots & \vdots & \ddots & \vdots \\ x_{n1} & x_{n2} & \cdots & x_{np} \\ \end{array} } \right) = \left( {\begin{array}{c} \textbf{x}_1^{\prime} \\ \vdots \\ \textbf{x}_n^{\prime} \\ \end{array} } \right) = (\textbf{x}_1, \cdots, \textbf{x}_n)'$$` `\(x_{ij}\)` é o valor da `\(j\)`-éssima coluna para a `\(i\)`-éssima observação. > Esta é a forma como usualmente "recebemos" os dados. --- ## Definição > .blue[**Análise Multivariada:** conjunto de técnicas utilizadas para analisar, entender e sumarizar dados de dimensão] `\(p \geq 2\)`. -- - **Redução de dimensão:** representar o _dataset_ com um menor número de _variáveis_ sem sacrificar informação*. - **Agrupamento:** de observações ou variáveis segundo as caracteristica semelhantes que elas possuem. - **Dependência entre variáveis:** Será que todas as variáveis são independentes? ou será que uma (ou mais) variáveis dependem de outras?. - **Predição:** predizer os valores de uma ou mais variáveis com base nos valores observados de outras variáveis. - **Classificação:** classificar novas observações em grupos pre-definidos com base nos valores de outras observações - **Teste de hipóteses:** formulado em termos dos parâmetros multivariados. --- class: inverse, right, middle # Datasets --- ### Swiss Bank Notes 6 características diferentes foram medidas em 200 notas antigas de 100 francos suíços. O conjunto de dados pode ser descarregado [aqui](https://raw.githubusercontent.com/ctruciosm/ctruciosm.github.io/master/datasets/swiss_bank_notes.csv). -- .pull-left[ - `\(X_1\)`: Comprimento da nota, - `\(X_2\)`: Altura do lado esquerdo da nota, - `\(X_3\)`: Altura do lado direito da nota, - `\(X_4\)`: Distância do quadro interno até a borda inferior - `\(X_5\)`: Distância do quadro interno até a borda superior, - `\(X_6\)`: Comprimento diagonal da nota. - `\(Y:\)` 1(falso) e 0(verdadeiro) ] .pull-right[  ] --- ### Swiss Bank Notes ```r library(tidyr) library(dplyr) library(ggplot2) library(GGally) library(plotly) library(aplpack) library(misc3d) ``` -- ```r swiss_notes <- read.csv("./datasets/swiss_bank_notes.csv") head(swiss_notes) ``` ``` ## X1 X2 X3 X4 X5 X6 Y ## 1 214.8 131.0 131.1 9.0 9.7 141.0 0 ## 2 214.6 129.7 129.7 8.1 9.5 141.7 0 ## 3 214.8 129.7 129.7 8.7 9.6 142.2 0 ## 4 214.8 129.7 129.6 7.5 10.4 142.0 0 ## 5 215.0 129.6 129.7 10.4 7.7 141.8 0 ## 6 215.7 130.8 130.5 9.0 10.1 141.4 0 ``` --- ### Dataset: Swiss Bank Notes ```r swiss_notes <- swiss_notes %>% rename("comprimento" = "X1", "alt_esq" = "X2", "alt_dir" = "X3", "borda_inf" = "X4", "borda_sup" = "X5", "diagonal" = "X6") %>% mutate(Y = recode(Y, "0" = "Original", "1" = "Falso")) %>% mutate(Y = factor(Y)) glimpse(swiss_notes) ``` ``` ## Rows: 200 ## Columns: 7 ## $ comprimento <dbl> 214.8, 214.6, 214.8, 214.8, 215.0, 215.7, 215.5, 214.5, 21… ## $ alt_esq <dbl> 131.0, 129.7, 129.7, 129.7, 129.6, 130.8, 129.5, 129.6, 12… ## $ alt_dir <dbl> 131.1, 129.7, 129.7, 129.6, 129.7, 130.5, 129.7, 129.2, 12… ## $ borda_inf <dbl> 9.0, 8.1, 8.7, 7.5, 10.4, 9.0, 7.9, 7.2, 8.2, 9.2, 7.9, 7.… ## $ borda_sup <dbl> 9.7, 9.5, 9.6, 10.4, 7.7, 10.1, 9.6, 10.7, 11.0, 10.0, 11.… ## $ diagonal <dbl> 141.0, 141.7, 142.2, 142.0, 141.8, 141.4, 141.6, 141.7, 14… ## $ Y <fct> Original, Original, Original, Original, Original, Original… ``` --- class: inverse, right, middle # Análise Exploratoria de Dados Multivariados --- ## Análise Exploratoria de Dados .blue[Antes de tentar construir algum modelo, precisamos primeiro fazer uma Análise Exploratória de Dados (EDA).] -- **O que podemos esperar da EDA?** -- - São algumas variáveis mais dispersas do que outras? - Os dados indicam a existencia de sub-grupos? - Temos outliers? - Os dados são Normais? - As variáveis estão correlacionadas? Quanto? - etc --- ## Análise Explotarória de Dados **Quais estatísticas, tabelas ou gráficos seriam interessantes?** -- - Vetor de médias - Matriz de covariância/correlação - 2D/3D Scatterplots - Boxplot - Caras de Chernoff-Flury - Curvas de Andrews - Coordenadas Paralelas - Histogramas - Gráfico de densidades (Kernel) - etc, --- class: inverse, right, middle # Análise Exploratoria de Dados Multivariados: Métodos Gráficos. --- ## EDA: Boxplot .panelset[ .panel[.panel-name[Plot] <!-- --> ] .panel[.panel-name[R Code] ```r swiss_notes_longer <- swiss_notes %>% pivot_longer(cols = c("comprimento", "alt_esq", "alt_dir", "borda_inf", "borda_sup", "diagonal"), names_to = "variaveis", values_to = "valores") swiss_notes_longer %>% ggplot() + geom_boxplot(aes(y = valores, x = Y, fill = Y)) + facet_wrap(.~ variaveis, scales = "free_y") ``` ]] --- ## EDA: Boxplot **Vantagens:** - Útil para ver locação (mediana), - Útil para ver assimetria (posição da mediana na caixa), - Útil para ver dispersão (comprimento da caixa e dos bigodes), - Útil para ver comprimento das caudas (comprimento dos bigodes) e - Útil para ver pontos discordantes. - **Bastante útil para comparar grupos.** -- **Desvantagens:** - Nos permite comparar apenas uma única variável ao mesmo tempo. - Não nos permite visualizar multimodalidade nem clusters* -- > Possiveis alternativas são [violin plots](https://chartio.com/learn/charts/violin-plot-complete-guide/) ou [bean plots](https://www.jstatsoft.org/article/view/v028c01). --- ## EDA: Densidades por Kernel .panelset[ .panel[.panel-name[Plot] <!-- --> ] .panel[.panel-name[R Code] ```r swiss_notes_longer %>% ggplot() + geom_density(aes(x = valores, color = Y)) + facet_wrap(.~ variaveis, scales = "free") ``` ] .panel[.panel-name[Plot 2] <!-- --> ]] --- ## EDA: Densidades por Kernel - Trazem uma ideia a respeito da distribuição dos dados. - Permite observar assimetria, dispersão e possíveis multimodalidades. - Utiliza uma função suavizada em lugar de apenas uma "caixa" (como nos histogramas). -- A forma geral do estimador Kernel é dada por `$$\hat{f}_h (x) = \dfrac{1}{n\times h} \displaystyle \sum_{i = 1}^n K\Big(\dfrac{x-x_i}{h} \Big).$$` -- > Diferentes Kernels ( `\(K(\cdot)\)` ) produzirão diferentes formas da densidade estimada. Ainda precisamos atribuir um valor apropriado para `\(h\)`. --- ## EDA: Densidades por Kernel Alguns dos Kernels mais utilizados são: - Uniforme: `\(K(u) = \frac{1}{2}I(|u| \leq 1)\)`, - Triangular: `\(K(u) = (1 - |u|) I(|u| \leq 1)\)` - Epanechnikov: `\(K(u) = \frac{3}{4} (1 - u^2) I(|u| \leq 1)\)`, - Biweight: `\(K(u) = \frac{15}{16} (1 - u^2)^2 I(|u| \leq 1)\)`, - Gaussiano: `\(K(u) = \frac{1}{\sqrt{2 \pi}} e^{-\frac{u^2}{2}}\)` -- > Existem formas de obter o melhor valor de `\(h\)` (por exemplo por validação-cruzada, embora este método seja demorado). Existem também regras de bolso que costumam funcionar bem na prática. Não nos preocuparemos com isso. --- ## EDA: Densidades por Kernel .panelset[ .panel[.panel-name[Densidades 2D] <!-- --> ] .panel[.panel-name[Densidades 3D] <!-- --> ] .panel[.panel-name[R Codes] ```r swiss_notes %>% ggplot(aes(x = borda_sup, y = diagonal)) + geom_density_2d() f <- kde3d(swiss_notes$borda_inf, swiss_notes$borda_sup, swiss_notes$diagonal, n = 15) contour3d(f$d, level = c(0.02, 0.04, 0.06), engine = "grid", fill = c(FALSE, FALSE, TRUE), col.mesh = c("green", "red", "blue")) ``` ]] --- ## EDA: Nuvem de pontos .panelset[ .panel[.panel-name[Plot 2D] <!-- --> ] .panel[.panel-name[R Code 2D] ```r ggpairs(swiss_notes, columns = c("comprimento", "alt_esq", "alt_dir", "borda_inf", "borda_sup", "diagonal"), upper = list(continuous = "points"), lower = list(continuous = "points"), mapping = aes(color = Y)) ``` ] .panel[.panel-name[Plot 3D] <div id="htmlwidget-e2c97055335c61c5058c" style="width:720px;height:396px;" class="plotly html-widget"></div> <script type="application/json" data-for="htmlwidget-e2c97055335c61c5058c">{"x":{"visdat":{"18ed66fc58ba":["function () ","plotlyVisDat"]},"cur_data":"18ed66fc58ba","attrs":{"18ed66fc58ba":{"x":[141,141.7,142.2,142,141.8,141.4,141.6,141.7,141.9,140.7,141.8,142.2,141.4,141.7,141.8,141.6,141.7,141.9,141.5,141.9,141.4,141.6,141.5,141.6,141.1,142.3,142.4,141.9,141.8,142,141.8,142.3,140.7,141,141.4,141.8,141.8,142,142.1,141.3,142.3,140.9,141.7,140.9,141,141.8,141.5,142,141.1,142,141.3,141.1,140.9,141.6,141.4,142,141.2,141.1,141.3,141.4,141.6,141.5,141.5,141.4,141.5,140.8,141.3,141.5,141.8,139.6,140.9,141.4,141.2,141.8,142.1,141.7,141.2,141,140.9,141.8,140.6,141,141.9,141.3,141.2,141.5,141.6,142.1,141.5,142,141.6,141.4,141.5,141.5,142,141.7,141.1,141.2,141.5,141.2,139.8,139.5,140.2,140.3,139.7,139.9,140.2,139.9,139.4,140.3,139.2,140.1,140.6,139.9,139.7,139.2,139.8,139.9,140,139.2,139.6,139.6,140.2,139.7,140.1,139.6,140.2,140,140.3,139.9,139.8,139.2,139.9,139.7,139.5,139.5,139.4,138.3,139.8,139.6,139.3,139.2,139.9,139.9,139.3,139.8,139.9,138.1,139.4,139.4,139.8,139,139.3,139.4,139.5,139.7,139.5,139.2,139.3,137.9,138.4,138.1,139.5,139.1,139.8,139.7,138.8,138.6,139.6,139.7,137.8,139.6,139.4,139.2,139.6,139,139.7,139.6,139.1,137.8,139.1,138.7,139.3,139.3,139.5,139.4,138.5,139.2,139.4,139.2,139.4,138.6,139.2,138.5,139.8,139.6,139.7,140,139.4,139.6],"y":[214.8,214.6,214.8,214.8,215,215.7,215.5,214.5,214.9,215.2,215.3,215.1,215.2,214.7,215.1,214.5,214.6,215,215.2,214.7,215,215.6,215.3,215.7,215.1,215.3,215.5,215.1,215.1,214.8,215.2,214.8,215,215.6,215.9,214.6,215.5,215.3,215.3,213.9,214.4,214.8,214.9,214.9,214.8,214.3,214.8,214.8,214.6,214.5,214.6,215.3,214.5,215.4,214.5,215.2,215.7,215,215.1,215.1,215.1,215.3,215.4,214.5,215,215.2,214.6,214.8,215.1,214.9,213.8,215.2,215,214.4,215.2,214.1,214.9,214.6,215.2,214.6,215.1,214.9,215.2,215.2,215.4,215.1,215.2,215,214.9,215,214.7,215.4,214.9,214.5,214.7,215.6,215,214.4,215.1,214.7,214.4,214.9,214.9,215,214.7,215,215.3,214.8,215,215.2,215.2,215.1,215.4,214.9,215.1,215.5,214.7,214.7,214.8,214.4,214.8,215.1,215.3,215.1,214.7,214.9,215,215.5,215.1,214.5,214.3,214.5,214.9,214.6,214.2,214.8,214.6,214.9,214.6,214.5,214.8,214.7,214.6,215,214.5,214.9,215,215.3,214.7,214.9,214.9,214.6,214.6,214.5,214.5,215.1,214.2,214.4,214.8,214.6,215.6,214.9,214.6,214.7,214.3,215.1,216.3,215.6,214.8,214.9,213.9,214.2,214.8,214.8,214.8,214.9,214.3,214.5,214.8,214.5,215,214.8,215,214.6,214.7,214.7,214.5,214.8,214.8,214.6,215.1,215.4,214.7,215,214.9,215,215.1,214.8,214.7,214.3],"z":[9,8.1,8.7,7.5,10.4,9,7.9,7.2,8.2,9.2,7.9,7.7,7.9,7.7,7.7,9.3,8.2,9,7.4,8.6,8.4,8.1,8.4,8.7,7.4,8,8.9,9.8,7.4,8.3,7.9,8.6,7.7,8.4,8.9,9.4,8.4,7.9,8.5,8.1,8.9,8.8,9.3,9,8.2,8.3,8.3,7.3,7.9,7.8,7.2,9.5,7.8,7.6,7.9,9.2,9.2,8.8,7.9,8.2,8.3,7.5,8,8,8.6,8.8,7.7,9.1,8.6,8,8.4,8.2,8.7,7.5,7.2,7.6,8.8,7.4,7.9,7.9,8.6,7.5,9,7.9,9,8.9,8.7,8.4,7.4,8,8.6,8.5,8.2,7.4,8.3,9,9.1,8,9.1,7.8,9.7,11,8.7,9.9,11.8,10.6,9.3,9.8,10,10.4,8,10.6,9.7,11.4,10.6,8.2,11.8,12.1,11,10.1,10.1,12.3,11.6,10.5,9.9,10.2,9.4,10.2,10.1,9.8,10.7,12.3,10.6,10.5,11,11.9,10.7,9.3,11.3,11.8,10,10.2,11.2,10.6,11.4,11.9,11.4,9.3,10.7,9.9,11.9,11.9,10.4,12.1,11,11.6,10.3,11.3,12.5,8.1,7.4,9.9,11.5,11.6,11.4,10.3,10,9.6,9.6,11.4,8.7,12,11.8,10.4,11.4,11.9,11.6,9.9,10.2,8.2,11.4,8,11,10.1,10.7,11.5,8,11.4,9.6,12.7,10.2,8.8,10.8,9.6,11.6,9.9,10.3,10.6,11.2,10.2],"mode":"markers","color":["Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Original","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso","Falso"],"alpha_stroke":1,"sizes":[10,100],"spans":[1,20],"type":"scatter3d"}},"layout":{"margin":{"b":40,"l":60,"t":25,"r":10},"scene":{"xaxis":{"title":[]},"yaxis":{"title":[]},"zaxis":{"title":[]}},"hovermode":"closest","showlegend":true},"source":"A","config":{"modeBarButtonsToAdd":["hoverclosest","hovercompare"],"showSendToCloud":false},"data":[{"x":[139.8,139.5,140.2,140.3,139.7,139.9,140.2,139.9,139.4,140.3,139.2,140.1,140.6,139.9,139.7,139.2,139.8,139.9,140,139.2,139.6,139.6,140.2,139.7,140.1,139.6,140.2,140,140.3,139.9,139.8,139.2,139.9,139.7,139.5,139.5,139.4,138.3,139.8,139.6,139.3,139.2,139.9,139.9,139.3,139.8,139.9,138.1,139.4,139.4,139.8,139,139.3,139.4,139.5,139.7,139.5,139.2,139.3,137.9,138.4,138.1,139.5,139.1,139.8,139.7,138.8,138.6,139.6,139.7,137.8,139.6,139.4,139.2,139.6,139,139.7,139.6,139.1,137.8,139.1,138.7,139.3,139.3,139.5,139.4,138.5,139.2,139.4,139.2,139.4,138.6,139.2,138.5,139.8,139.6,139.7,140,139.4,139.6],"y":[214.4,214.9,214.9,215,214.7,215,215.3,214.8,215,215.2,215.2,215.1,215.4,214.9,215.1,215.5,214.7,214.7,214.8,214.4,214.8,215.1,215.3,215.1,214.7,214.9,215,215.5,215.1,214.5,214.3,214.5,214.9,214.6,214.2,214.8,214.6,214.9,214.6,214.5,214.8,214.7,214.6,215,214.5,214.9,215,215.3,214.7,214.9,214.9,214.6,214.6,214.5,214.5,215.1,214.2,214.4,214.8,214.6,215.6,214.9,214.6,214.7,214.3,215.1,216.3,215.6,214.8,214.9,213.9,214.2,214.8,214.8,214.8,214.9,214.3,214.5,214.8,214.5,215,214.8,215,214.6,214.7,214.7,214.5,214.8,214.8,214.6,215.1,215.4,214.7,215,214.9,215,215.1,214.8,214.7,214.3],"z":[9.7,11,8.7,9.9,11.8,10.6,9.3,9.8,10,10.4,8,10.6,9.7,11.4,10.6,8.2,11.8,12.1,11,10.1,10.1,12.3,11.6,10.5,9.9,10.2,9.4,10.2,10.1,9.8,10.7,12.3,10.6,10.5,11,11.9,10.7,9.3,11.3,11.8,10,10.2,11.2,10.6,11.4,11.9,11.4,9.3,10.7,9.9,11.9,11.9,10.4,12.1,11,11.6,10.3,11.3,12.5,8.1,7.4,9.9,11.5,11.6,11.4,10.3,10,9.6,9.6,11.4,8.7,12,11.8,10.4,11.4,11.9,11.6,9.9,10.2,8.2,11.4,8,11,10.1,10.7,11.5,8,11.4,9.6,12.7,10.2,8.8,10.8,9.6,11.6,9.9,10.3,10.6,11.2,10.2],"mode":"markers","type":"scatter3d","name":"Falso","marker":{"color":"rgba(102,194,165,1)","line":{"color":"rgba(102,194,165,1)"}},"textfont":{"color":"rgba(102,194,165,1)"},"error_y":{"color":"rgba(102,194,165,1)"},"error_x":{"color":"rgba(102,194,165,1)"},"line":{"color":"rgba(102,194,165,1)"},"frame":null},{"x":[141,141.7,142.2,142,141.8,141.4,141.6,141.7,141.9,140.7,141.8,142.2,141.4,141.7,141.8,141.6,141.7,141.9,141.5,141.9,141.4,141.6,141.5,141.6,141.1,142.3,142.4,141.9,141.8,142,141.8,142.3,140.7,141,141.4,141.8,141.8,142,142.1,141.3,142.3,140.9,141.7,140.9,141,141.8,141.5,142,141.1,142,141.3,141.1,140.9,141.6,141.4,142,141.2,141.1,141.3,141.4,141.6,141.5,141.5,141.4,141.5,140.8,141.3,141.5,141.8,139.6,140.9,141.4,141.2,141.8,142.1,141.7,141.2,141,140.9,141.8,140.6,141,141.9,141.3,141.2,141.5,141.6,142.1,141.5,142,141.6,141.4,141.5,141.5,142,141.7,141.1,141.2,141.5,141.2],"y":[214.8,214.6,214.8,214.8,215,215.7,215.5,214.5,214.9,215.2,215.3,215.1,215.2,214.7,215.1,214.5,214.6,215,215.2,214.7,215,215.6,215.3,215.7,215.1,215.3,215.5,215.1,215.1,214.8,215.2,214.8,215,215.6,215.9,214.6,215.5,215.3,215.3,213.9,214.4,214.8,214.9,214.9,214.8,214.3,214.8,214.8,214.6,214.5,214.6,215.3,214.5,215.4,214.5,215.2,215.7,215,215.1,215.1,215.1,215.3,215.4,214.5,215,215.2,214.6,214.8,215.1,214.9,213.8,215.2,215,214.4,215.2,214.1,214.9,214.6,215.2,214.6,215.1,214.9,215.2,215.2,215.4,215.1,215.2,215,214.9,215,214.7,215.4,214.9,214.5,214.7,215.6,215,214.4,215.1,214.7],"z":[9,8.1,8.7,7.5,10.4,9,7.9,7.2,8.2,9.2,7.9,7.7,7.9,7.7,7.7,9.3,8.2,9,7.4,8.6,8.4,8.1,8.4,8.7,7.4,8,8.9,9.8,7.4,8.3,7.9,8.6,7.7,8.4,8.9,9.4,8.4,7.9,8.5,8.1,8.9,8.8,9.3,9,8.2,8.3,8.3,7.3,7.9,7.8,7.2,9.5,7.8,7.6,7.9,9.2,9.2,8.8,7.9,8.2,8.3,7.5,8,8,8.6,8.8,7.7,9.1,8.6,8,8.4,8.2,8.7,7.5,7.2,7.6,8.8,7.4,7.9,7.9,8.6,7.5,9,7.9,9,8.9,8.7,8.4,7.4,8,8.6,8.5,8.2,7.4,8.3,9,9.1,8,9.1,7.8],"mode":"markers","type":"scatter3d","name":"Original","marker":{"color":"rgba(141,160,203,1)","line":{"color":"rgba(141,160,203,1)"}},"textfont":{"color":"rgba(141,160,203,1)"},"error_y":{"color":"rgba(141,160,203,1)"},"error_x":{"color":"rgba(141,160,203,1)"},"line":{"color":"rgba(141,160,203,1)"},"frame":null}],"highlight":{"on":"plotly_click","persistent":false,"dynamic":false,"selectize":false,"opacityDim":0.2,"selected":{"opacity":1},"debounce":0},"shinyEvents":["plotly_hover","plotly_click","plotly_selected","plotly_relayout","plotly_brushed","plotly_brushing","plotly_clickannotation","plotly_doubleclick","plotly_deselect","plotly_afterplot","plotly_sunburstclick"],"base_url":"https://plot.ly"},"evals":[],"jsHooks":[]}</script> ] .panel[.panel-name[R Code 3D] ```r plot_ly(x = swiss_notes$diagonal, y = swiss_notes$comprimento, z = swiss_notes$borda_inf, type = "scatter3d", mode = "markers", color = swiss_notes$Y) ``` ]] --- ## EDA: Nuvem de pontos - São gráficos bi ou tri variados de uma variável versus outra(s). - Ajudam a entender a relação entre as variáveis no conjunto de dados. - Úteis para identificar outliers ou sub-clusters - São bastante populares e fáceis de entender. -- **Desvantagens:** - Apenas é possível comparar varíaveis 2 a 2 (ou 3 a 3) - A medida que `\(p\)` cresce, sequências de nuvens de pontos são difíceis de interpretar. - Se tivermos várias observações, digamos `\(x = (2, 3)\)`, aparecerão todas como um único ponto sobreposto (embora existam formas de lidar com isso) --- ## EDA: Caras de Chernoff-Flury .panelset[ .panel[.panel-name[Plot] <!-- --> ``` ## effect of variables: ## modified item Var ## "height of face " "comprimento" ## "width of face " "alt_esq" ## "structure of face" "alt_dir" ## "height of mouth " "borda_inf" ## "width of mouth " "borda_sup" ## "smiling " "diagonal" ## "height of eyes " "comprimento" ## "width of eyes " "alt_esq" ## "height of hair " "alt_dir" ## "width of hair " "borda_inf" ## "style of hair " "borda_sup" ## "height of nose " "diagonal" ## "width of nose " "comprimento" ## "width of ear " "alt_esq" ## "height of ear " "alt_dir" ``` ] .panel[.panel-name[R Code] ```r faces(swiss_notes[1:25, 1:6]) ``` ]] --- ## EDA: Caras de Chernoff-Flury - A medida que `\(p\)` cresce, é mais difícil visualizar as observações em 2D ou mesmo 3D. - Se quisermos visualizar as observações `\(p\)`-dimensionais em 2D, precisamos utilizar procedimentos alternativos, como por exemplo, as caras de Chernoff-Flury. - As caras de Chernoff-Flury ([Chernoff 1973](https://www.tandfonline.com/doi/abs/10.1080/01621459.1973.10482434) e [Flury and Riedwyl 1988](https://www.amazon.com/Multivariate-Statistics-Practical-Bernhard-Flury/dp/9401070415)) permitem representar dados multidimensionais em caras/rostos. - Permite identificar outliers. - Permite identificar sub-clusters. -- **Desvantagens:** - Se tivermos muitas observações, fica bastante difícil diferenciar (ou mesmo visualizar em uma única folha) as caras. - Pode ser utilizado apenas em dimensões moderadas --- ## EDA: Curvas de Andrews .panelset[ .panel[.panel-name[Plot] <!-- --> ] .panel[.panel-name[R Code] ```r andrews_curve <- function(x){ p <- ncol(x); n <- nrow(x) t <- seq(0, 2*pi, by = 0.01) nt <- length(t) z <- x for (l in 1:p) { z[, l] = (x[, l] - min(x[, l]))/(max(x[, l]) - min(x[, l])) } f <- z[,1]/sqrt(2)*matrix(1, ncol = nt, nrow = n) for (i in seq(2, p, by = 2)) { f <- f + z[,i]*matrix(sin((i/2)*t), ncol = nt, nrow = n, byrow = TRUE) if (i + 1 <= p) f <- f + z[, i + 1]*matrix(cos((i/2)*t), ncol = nt, nrow = n, byrow = TRUE) } r <- data.frame(t(f)) r$t <- t r <- r %>% pivot_longer(cols = 1:n, names_to = "rows", values_to = "values") return(r) } A <- andrews_curve(swiss_notes[,1:6]) ggplot(A, aes(x = t, y = values, color = rows)) + geom_line() + theme(legend.position = "none") ``` ]] --- ## EDA: Curvas de Andrews - Elas permitem representar observações multidimensionais em curvas e não mais em rostos (são uma alternativas às caras de Chernoff-Flury). - As curvas são obtidas da seguinte forma: -- `$$f_i(t)= \frac{X_{i1}}{\sqrt{2}} + X_{i2} \sin(t) + X_{i3} \cos(t) + \cdots + X_{ip} \sin(\frac{p}{2}t)$$` -- > **A ordem das variáveis é importante**, repare que se as últimas variáveis terão uma pequena contribuição na curva (caem na parte de alta frequência da curva). -- [Existem modificações da função apresentada acima](https://rdrr.io/cran/andrews/man/andrews.html). -- > **Obs:** para melhor visualização levar as variáveis para uma escala 0-1 --- ## EDA: Coordenadas paralelas .panelset[ .panel[.panel-name[Plot 1] <!-- --> ] .panel[.panel-name[R Code] ```r ggparcoord(swiss_notes, columns = 1:6, groupColumn = "Y", scale = "uniminmax") ``` ]] --- ## EDA: Coordenadas paralelas A ideia é olhar todas as variáveis de uma vez em uma plano bidimentional. Para isto, tracejamos retas em coordenadas paralelas da seguinte forma: -- - Cada variável é um eixo (teremos tantos eixos paralelos quanto variáveis disponíveis). - Transformar as variáveis para todas terem `\(max = 1\)` e `\(min = 0\)`. - Na nova escala (0-1), localizar o valor de cada observação (em cada uma das variáveis) em cada eixo. - Unir os pontos com linhas retas. -- > Utilizado para detectar sub-clusters, relações lineares e outliers. --- ## EDA: Coordenadas paralelas .panelset[ .panel[.panel-name[Rel Linear 1] ```r ggparcoord(car_data, columns = c(8, 11), groupColumn = "procedencia", scale = "uniminmax") ``` <!-- --> ```r cor(car_data[, c(8, 11)])[1,2] ``` ``` ## [1] 0.9006063 ``` ] .panel[.panel-name[Rel Linear 2] ```r ggparcoord(car_data, columns = c(2, 8), groupColumn = "procedencia", scale = "uniminmax") ``` <!-- --> ```r cor(car_data[, c(2, 8)])[1,2] ``` ``` ## [1] -0.8228964 ``` ] .panel[.panel-name[Outliers] ```r ggparcoord(car_data, columns = 5:7, groupColumn = "procedencia", scale = "uniminmax") ``` <!-- --> ]] --- class: inverse, right, middle # Análise Exploratoria de Dados Multivariados: Estatísticas Resumo. --- ## Vetor de médias Seja `\(\bar{x}_i = \dfrac{1}{n}\displaystyle \sum_{k = 1}^nx_{ki}\)` a média amostral da `\(i\)`-ésima variável. O vetor de médias amostrais é dado por `$$\bar{\textbf{x}} = (\bar{x}_1, \cdots, \bar{x}_p)' = \dfrac{1}{n} \displaystyle \sum_{i = 1}^n \textbf{x}_i = \dfrac{1}{n} \textbf{x}' \textbf{1},$$` em que `\(\textbf{1}\)` é o vetor coluna de tamanho `\(n\)` com todos os elementos iguais a 1. --- ## Vetor de médias ```r swiss_notes %>% group_by(Y) %>% summarise_if(is.numeric, mean) ``` ``` ## # A tibble: 2 × 7 ## Y comprimento alt_esq alt_dir borda_inf borda_sup diagonal ## <fct> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> ## 1 Falso 215. 130. 130. 10.5 11.1 139. ## 2 Original 215. 130. 130. 8.30 10.2 142. ``` --- ## Matriz de covariância e correlação As matrizes de covariância e correlação amostral são, respectivamente, `$$S = \dfrac{1}{n} \displaystyle \sum_{i = 1}^n (\textbf{x}_i - \bar{\textbf{x}})(\textbf{x}_i - \bar{\textbf{x}})' \quad \text{e} \quad R = D^{-1/2}SD^{-1/2},$$` em que `\(\textbf{x}_i = (x_{i1}, \cdots, x_{ip})'\)`, `\(\bar{\textbf{x}} = (\bar{x}_1, \cdots, \bar{x}_p)'\)` e `\(D = Diag(S)\)`. -- Pode-se mostrar que, `$$S= \dfrac{1}{n} \textbf{x}' \underbrace{(\textbf{I} - \dfrac{1}{n} \textbf{1}\textbf{1}')}_{\textbf{H}} \textbf{x} = \dfrac{1}{n} \textbf{x}'\textbf{H}\textbf{x}.$$` --- ## Matriz de covariância e correlação ```r swiss_notes %>% select(-Y) %>% cor() %>% round(3) ``` ``` ## comprimento alt_esq alt_dir borda_inf borda_sup diagonal ## comprimento 1.000 0.231 0.152 -0.190 -0.061 0.194 ## alt_esq 0.231 1.000 0.743 0.414 0.362 -0.503 ## alt_dir 0.152 0.743 1.000 0.487 0.401 -0.516 ## borda_inf -0.190 0.414 0.487 1.000 0.142 -0.623 ## borda_sup -0.061 0.362 0.401 0.142 1.000 -0.594 ## diagonal 0.194 -0.503 -0.516 -0.623 -0.594 1.000 ``` --- ## Outras medidas resumo - Variância generalizada `\(|S|\)`. - Variância total `\(Tr(S)\)` - Variância efeitva `\(|S|^{1/p}\)` - Coeficiente de assimetria multivariado `\(A_p = \dfrac{1}{n^2} \displaystyle \sum_{i = 1}^n \sum_{j = 1}^n d_{ij}^3.\)` - Coeficiente de curtose multivariado `\(K_p = \dfrac{1}{n} \displaystyle \sum_{i=1}^n d_{ii}^2.\)` (em que `\(d_{ij} = (\textbf{x}_i - \bar{\textbf{x}})'S^{-1}(\textbf{x}_j - \bar{\textbf{x}})\)` é a distância de Mahalanobis). --- ### Referências - [Härdle, W. K., & Simar, L. (2019). Applied Multivariate Statistical Analysis. Fifth Editon. Springer Nature.](https://link.springer.com/book/10.1007/978-3-030-26006-4) Capítulo 1 - Koch, I. (2013). Analysis of multivariate and high-dimensional data (Vol. 32). Cambridge University Press. Capítulo 1 - Mardia, K. V., Kent, J. T., & Bibby, J, M. (1979). Multivariate Analysis. Academic Press. Capítulo 1 -- > Dica: Faça uma revisão de algebra matricial antes da próxima aula (propriedades de determinante, traço, partição de matrizes, etc.)