Rows: 526

Columns: 24

$ wage <dbl> 3.10, 3.24, 3.00, 6.00, 5.30, 8.75, 11.25, 5.00, 3.60, 18.18,…

$ educ <int> 11, 12, 11, 8, 12, 16, 18, 12, 12, 17, 16, 13, 12, 12, 12, 16…

$ exper <int> 2, 22, 2, 44, 7, 9, 15, 5, 26, 22, 8, 3, 15, 18, 31, 14, 10, …

$ tenure <int> 0, 2, 0, 28, 2, 8, 7, 3, 4, 21, 2, 0, 0, 3, 15, 0, 0, 10, 0, …

$ nonwhite <int> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0…

$ female <int> 1, 1, 0, 0, 0, 0, 0, 1, 1, 0, 1, 1, 0, 0, 0, 0, 1, 1, 1, 1, 1…

$ married <int> 0, 1, 0, 1, 1, 1, 0, 0, 0, 1, 0, 0, 1, 0, 1, 1, 1, 0, 1, 1, 0…

$ numdep <int> 2, 3, 2, 0, 1, 0, 0, 0, 2, 0, 0, 0, 2, 0, 1, 1, 0, 0, 3, 0, 0…

$ smsa <int> 1, 1, 0, 1, 0, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1…

$ northcen <int> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0…

$ south <int> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0…

$ west <int> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1…

$ construc <int> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0…

$ ndurman <int> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0…

$ trcommpu <int> 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0…

$ trade <int> 0, 0, 1, 0, 0, 0, 1, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0…

$ services <int> 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0…

$ profserv <int> 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 0, 0, 0, 1, 0, 1, 0, 1, 1…

$ profocc <int> 0, 0, 0, 0, 0, 1, 1, 1, 1, 1, 1, 0, 0, 0, 1, 1, 0, 1, 0, 0, 1…

$ clerocc <int> 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 0, 0, 0, 0…

$ servocc <int> 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0…

$ lwage <dbl> 1.1314021, 1.1755733, 1.0986123, 1.7917595, 1.6677068, 2.1690…

$ expersq <int> 4, 484, 4, 1936, 49, 81, 225, 25, 676, 484, 64, 9, 225, 324, …

$ tenursq <int> 0, 4, 0, 784, 4, 64, 49, 9, 16, 441, 4, 0, 0, 9, 225, 0, 0, 1…ME715 - Econometria

Modelo de Regressão Linear

ctrucios@unicamp.br

Instituto de Matemática, Estatística e Computação Científica (IMECC),

Universidade Estadual de Campinas (UNICAMP).

O modelo

O modelo

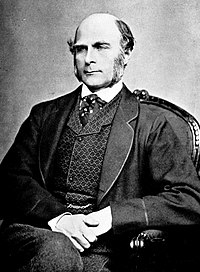

Embora Legendre e Gauss tenham utilizado o método de mínimos quadrados muito antes do que Galton (a começos de 1800), o termo “regressão” aparece por primeira vez em 1886, no trabalho de Francis Galton intitulado Regression towards mediocrity in hereditary stature e é a este a quem lhe é atribuido o método.

O modelo

Quando trabalhamos com modelos de regressão, estamos interessados em “explicar Y em termos de X” ou “estudar como Y varia com variações em X”.

Regressão Linear Simples

\[Y = \beta_0 + \beta_1 X_1 + u\]

Regressão Linear Multipla

\[Y = \beta_0 + \beta_1 X_1 + \beta_2 X_2 + \cdots + \beta_k X_k + u\]

| Y | Xs |

|---|---|

| variável dependente | variável independente |

| variável explicada | variável explicativa |

| variável resposta | variável de controle |

| variável prevista | variável previsora |

| regressando | regressor |

| variável target | covariável / feature |

\(u\) é o termo de erro ou perturbação, representa outros fatores (não observados), além dos \(X\), que afetam \(Y\).

O modelo

Pense no modelo de regressão linear simples. Se todos os outros fatores em \(u\) permanecerem fixos, \[\Delta Y = \beta_1 \Delta X_1, \quad \text{pois} \quad \Delta u = 0.\]

- A variação de \(Y\) é \(\beta_1\) multiplicado pela variação em \(X_1\).

- \(\beta_1\) é o parâmetro de inclinação da relação entre \(Y\) e \(X_1\) (mantendo fixos todos os outros fatores).

- \(\beta_0\) é chamado parâmetro de intercepto

O modelo

Dado que \(\beta_1\) mede o efeito de \(X_1\) sobre \(Y\) mantendo todos os outros fatores fixos, então é facil tirar conclusões ceteris paribus, certo?

Infelizmente não…

Como podemos aprender algo sobre o efeito ceteris paribus de \(X_1\) sobre \(Y\) mantendo os outros fatores fixos se estamos ignorando todos os outros fatores?

O modelo

Então, como podemos estar certos de que estamos capturando uma relação ceteris paribus entre Y e \(X_1\)?

Precisamos de algumas suposições (hipóteses do modelo) que restrinjam a maneira como \(u\) está relacionado com \(X_1\) (respectivamente \(\textbf{X}\))

Hipóteses do modelo

Hipóteses do modelo

Note

- HRLM1: O modelo populacional é linear nos parâmetros, \(Y = \beta_0 + \beta_1 X_1 + \beta_2 X_2 + \ldots + \beta_k X_k + u\) (equivalentemete, em forma matrcial, \(Y = \textbf{X} \beta + \textbf{u}\)).

- HRLM2: \((Y_1, X_{1,1}, \ldots, X_{1,k}), \cdots, (Y_n, X_{n,1}, \ldots, X_{n,k})\) constituem uma a.a. de tamanho \(n\) do modelo populacional.

- HRLM3: Não existe colinearidade perfeita entre as variáveis independentes e nenhuma das variáveis independentes é constante.

- HRLM4: \(\mathbb{E}(\textbf{u}|\textbf{X}) = 0\)

- HRLM5: Os erros tem variância constante (homocedasticidade), \(\mathbb{V}(\textbf{u}|\textbf{X}) = \sigma^2 \textbf{I}\)

Estas hipóteses são conhecidas como as hipóteses de Gauss-Markov.

Interpretação

Interpretação

Aplicando \(\mathbb{E}(\cdot|X)\) no modelo de RLS,

\[\mathbb{E}(Y|X) = \beta_0 + \beta_1 X,\]

ou seja, o aumento em uma unidade em \(X\) faz com que o valor esperado de \(Y\) varie em \(\beta_1\) unidades. Por outro lado, o valor esperado de \(Y\) quando \(X = 0\) é \(\beta_0\).

No caso do modelo de RLM, \[\mathbb{E}(Y|\textbf{X}) = \beta_0 + \beta_1 X_1 + \cdots + \beta_k X_k,\quad ou \quad \mathbb{E}(Y|\textbf{X}) = \textbf{X} \beta\]

e temos uma interpretação semelhante.

Interpretação

Na prática, nunca conhecemos os \(\beta\)s e os estimamos. Assim,

Regressão Linear Simples

\[\hat{y}_i = \hat{\beta}_0 + \hat{\beta}_1 x_{i},\]

- \(\hat{u}_i = y_i - \hat{y}_i = y_i - \hat{\beta}_0 - \hat{\beta}_1 x_i\).

- \(\Delta \hat{y} = \hat{\beta}_1 \Delta x\) (\(\hat{\beta}_1\) nos diz quanto varia \(\hat{y}\) quando \(x\) aumenta em uma unidade).

- Quando \(X = x_i\), estimamos o valor de \(y_i\) em \(\hat{\beta}_0 + \hat{\beta}_1 x_i\).

Regressão Linear Multipla

\[\hat{y}_i = \hat{\beta}_0 + \hat{\beta}_1 x_{i,1} + \cdots + \hat{\beta}_k x_{i,k},\]

- \(\hat{u}_i = y_i - \hat{y}_i = y_i - \hat{\beta}_0 - \hat{\beta}_1 x_{i,1} - \cdots - \hat{\beta}_k x_{i,k}\).

- \(\Delta \hat{y} = \hat{\beta}_1 \Delta x_1\) (\(\hat{\beta}_1\) nos diz quando varia \(\hat{y}\) quando \(x_1\) aumenta em uma unidade e todos os outros fatores permanecem fixos.).

- Quando \(\textbf{X} = \textbf{x}_i\), estimamos o valor de \(y_i\) em \(\hat{\beta}_0 + \hat{\beta}_1 x_{i,1} + \cdots + \hat{\beta}_k x_{i,k}\).

Interpretação

Warning

- \(\hat{u}_i = y_i - \hat{y}_i\) é chamado de resíduo.

- Resíduo (\(\hat{u}_i\)) e Erro (\(u_i\)) não são a mesma coisa!

- De fato, é facil ver que \(\hat{u}_i = u_i + (\beta_1 - \hat{\beta}_1) x_{i,1} + \cdots + (\beta_k - \hat{\beta}_k) x_{i,k}\)

Interpretação

Case:

Imagine que estamos interessamos em saber se os anos de educação formal (educ) influenciam o salário-hora (wage). Para isto, utilizamos o conjunto de datos WAGE1, que contém informação de 516 pessoas que fazem parte da população economicamente ativa dos Estados Unidos em 1976.

Interpretação

Como queremos \[\underbrace{wage}_{Y} = \beta_0 + \beta_1 \underbrace{educ}_{X} + u,\] utilizamos um modelo de regressão linear simples.

Interpretação

- Isso significa que uma pessoa sem nenhum ano de eduacação formal tem um salário-hora de \(\approx\) USD$-0.90?

- Isso faz sentido? O que poderia estar acontecendo?

Resultados contra-intuitivos precisam de maior atenção. Se avaliarmos a amostra, temos pouquissimas observações com níveis de educação baixos. Assim, não é de se surpreender que a reta de regressão não faça boas predições para níveis de educação muito baixos.

Estimação

Estimação

No caso mais geral (regressão linear multipla), pode-se provar que o estimador MQO é dado por \[\hat{\beta} = (X'X)^{-1}X'Y\]

Demostração: (no quadro)

Estimação

Na prática, utilizamos algum software para fazer a estimação e não nos preocupamos com a implementação (embora, saber implementar é importante).

Propriedades

Propriedades

Além das suas propriedades assintóticas (que veremos na próxima aula), o estimador MQO possui algumas propriedades interessantes, entre elas:

- \(\mathbb{E}(\hat{\beta}) = \beta\)

- \(\mathbb{V}(\hat{\beta}|\textbf{X}) = \sigma^2 (X'X)^{-1}\)

- \(\displaystyle \sum_{i = 1}^n \hat{u}_i = 0\)

- \(\displaystyle \sum_{i = 1}^n x_{i,k} \hat{u}_i = 0,\quad \forall k\)

Teorema de Gauss-Markov

Teorema de Gauss-Markov

Teorema

Sob HRLM1–HRLM5, \(\hat{\beta}\) é o melhor estimador linear não viesado de \(\beta\).

Demostração (no quadro)

Carlos Trucíos (IMECC/UNICAMP) | ME715 - Econometria | ctruciosm.github.io